'With great power, comes great responsibility'

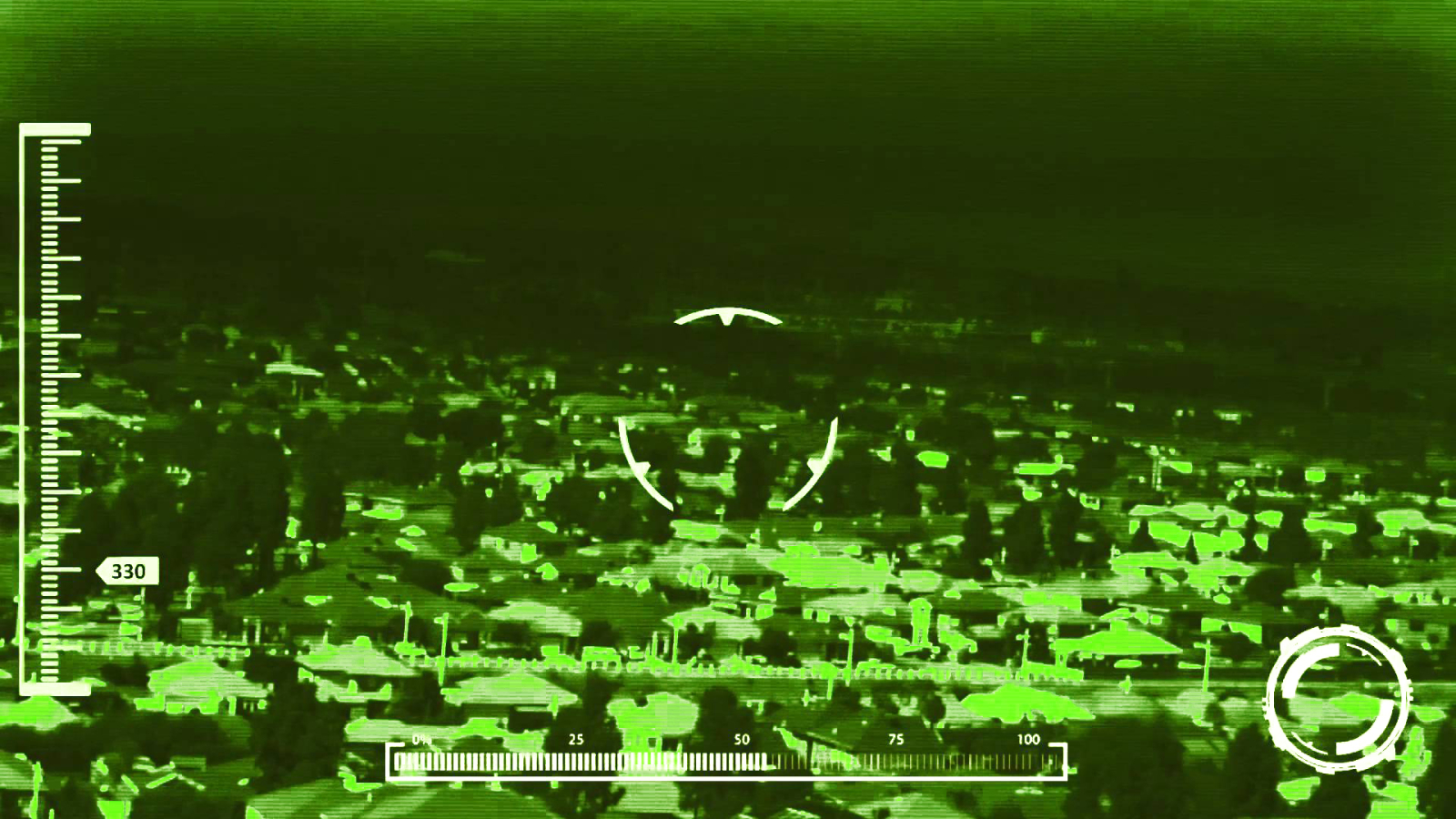

Nederlandse F16's voeren sinds vorige week 'slimme' bombardementen uit op Syrië. Precisiebommen die geleid worden via een laser en GPS. We hebben zelfrijdende auto's, slimme huizen, en een digitale wereldkampioen schaken. Ook oorlogsvoering wordt meer geautomatiseerd. Technologie en kunstmatige intelligentie zijn overal om ons heen, zichtbaar en onzichtbaar. Ze zijn geïntegreerd geraakt in ons wereldbeeld op een manier dat ze ons vaak niet eens opvallen.

In de eerste SG Actueel nemen prof. dr. John-Jules Meyer (Informatica, UU) en dr. Merel Noorman (techniekfilosofe, UM) ons mee in de wereld van de kunstmatige intelligentie (KI). Hoe intelligent zijn al die systemen nu precies? En hoe zit het met verantwoordelijkheid als robots zelfstandiger handelen? Of als ze gebruikt worden in oorlogssituaties zoals nu in Syrië?

Het is belangrijk een onderscheid te maken tussen verschillende vormen van intelligentie, stelt Meyer. Op gerichte taken presteert KI vaak beter dan de mens. Denk bijvoorbeeld aan een krachtige rekenmachine. Toch is ons doorsnee begrip van intelligentie breder dan dat. Echt slimme systemen moeten praktisch kunnen redeneren, communiceren, beslissen over acties, en acties ondernemen. Dit komt in de buurt van het programmeren van een kunstmatig brein. Maar zo ver zijn we nog niet. Systemen worden wel steeds autonomer. Ze integreren informatie uit de omgeving, reageren, nemen initiatief, ze leren van hun fouten en kunnen handelen zonder tussenkomst van mensen.

Hoe je de intelligentie van robots ook definieert, doordat ze steeds zelfstandiger handelen wordt het toeschrijven van verantwoordelijkheid problematisch. Bij een koffiezetapparaat is dit geen kwestie, maar wat als drones zelf hun doelwit kiezen en dat uitschakelen? Verantwoordelijkheid vervult een belangrijke rol binnen het rechtssysteem en de maatschappij. Mensen zijn alerter als ze zich ergens verantwoordelijk voor voelen en zullen meer weloverwogen keuzes maken. Hoe zit dit bij autonome robots?

Een robot voelt niet. Een robot is niet moreel, noch immoreel. Robots zijn amoreel. Ze proberen de doelen te bereiken waar ze voor geprogrammeerd zijn en hebben geen idee van goed of kwaad. Als een immorele handeling nodig is om een doel te bereiken, zal de robot geen ethische overweging maken. Prof. dr. Sabine Roeser (Ethiek, TU Delft) pleit in een artikel van De Correspondent voor de waardevolle rol van emoties in het maken van onze beslissingen. "Zou je emoties ook niet in een robot kunnen programmeren?" vraagt iemand uit de zaal. Roeser merkt in het artikel op dat emoties gebaseerd zijn op waarden die mensen belangrijk vinden. We voelen boosheid omdat iets in strijd is met onze overtuigingen. Het programmeren van waarden zou misschien al haalbaarder zijn. Volgens Noorman zijn ze hier in Amerika mee bezig, maar het blijft een complex verhaal om ethiek en emotie te programmeren.

"We are facing a responsibility gap."

Maar zelfs met autonome KI die weloverwogen, emotioneel geladen keuzes maakt, blijft het verantwoordelijkheidsprobleem bestaan. Is de robot zelf verantwoordelijk of de programmeur? Er is geen duidelijke grens. Vergelijk het met ouders en hun kinderen. Tot wanneer zijn ouders verantwoordelijk voor hun gedrag? Tot hun 16e? Tot ze uit huis gaan? Wettelijk gezien hebben we die grens op 18 jaar gezet. Dan word je beoordeeld als volwassene. Maar wanneer is een robot volwassen? Noorman citeert technisch ethicus Andreas Matthias: "We are facing a responsibility gap." Ons klassieke idee van verantwoordelijkheid is beperkt als het aankomt op technologie. De manier waarop we verantwoordelijkheid toeschrijven aan mensen, werkt niet op robots. Noorman: "Bekende manieren waarop verantwoordelijkheid wordt toebedeeld moeten worden heroverwogen. Er moet opnieuw geëvalueerd worden wie waar wat doet."

Verantwoordelijkheden van mensen zijn al lastig en opgeknipt, maar het bestaan van een 'responsibility gap', een grote kloof, is een angstaanjagend idee. Zeker als het aankomt op geautomatiseerde wapens. Een groep van NGO's en KI-specialisten is daarom in 2012 een campagne gestart om volledig geautomatiseerde wapens uit voorzorg te verbieden. Noorman staat achter deze campagne. We kiezen ervoor wie we verantwoordelijkheid toeschrijven en we moeten er volgens haar niet voor kiezen om verantwoordelijkheid voor doden en gewonden af te schuiven op robots. Meyer is het met haar eens: "Technologische ontwikkeling zal altijd doorgaan, dat kan je niet stoppen. Het is aan ons om de technologieën op de juiste manier te gebruiken."